今回はAMDがRyzen™ AI PCまたはRadeon™ 7000シリーズ(RX 6900/6800 シリーズでも可)でLLMを動かせる方法を公開していたので試してみます。

詳細はこちら

How to run a Large Language Model (LLM) on your AM… – AMD Community

LM Studioとは?

LM StudioはローカルPCで公開されているさまざまなLLMを動かせるソフトウェアです。

LM Studioを使えば、以下のことができます。

- 自分のPCでLLMを完全オフラインで実行

- アプリ内のチャットUIやOpenAI互換のローカルサーバーを通じてモデルを使用

- HuggingFaceリポジトリから互換性のあるモデルファイルを任意にダウンロード可能

- アプリのホームページで注目のLLMを発見

動作要件としてM1/M2/M3 Mac、またはAVX2をサポートするプロセッサを搭載したWindows PCまたはLinux(ベータ版)で利用可能です。

Radeon GPUでLM Studioを使う方法

環境

- Windows10

- メモリ 16GB

- Radeon RX6800

今回はAMDのGPUを使うので次のURLからLM Studioをダウンロードします。

LM Studio – Discover, download, and run local LLMs

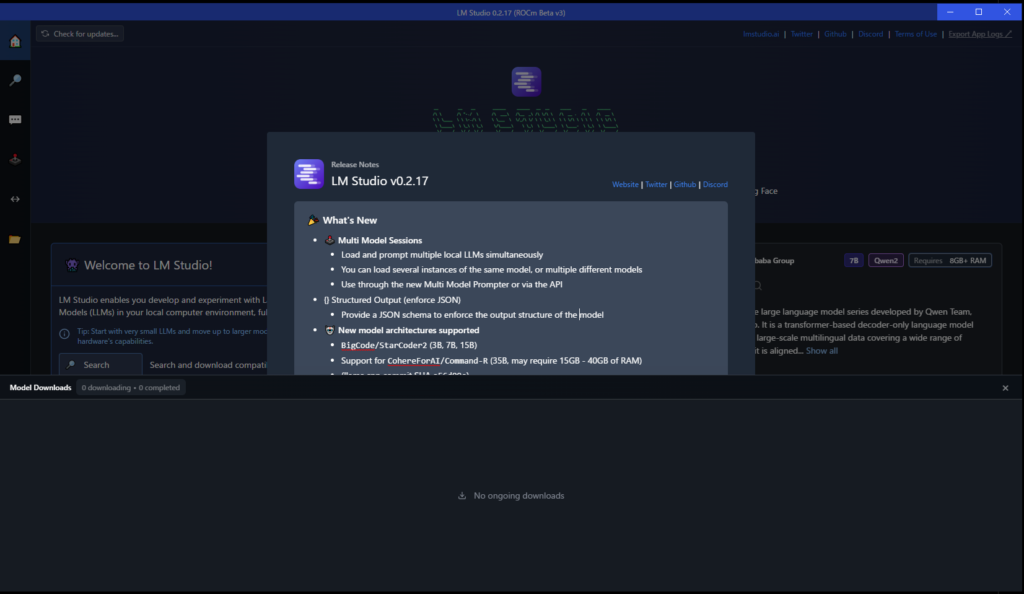

インストーラーを実行し、インストールすると、ソフトウェアが自動的に起動します

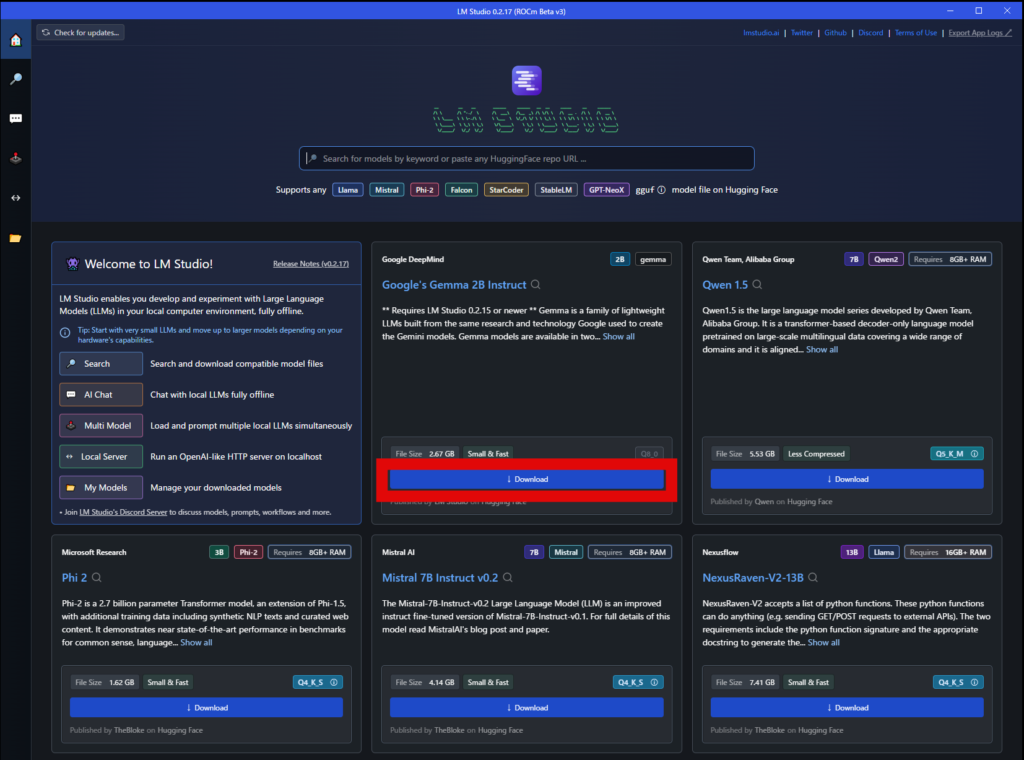

Home画面で色んなLLMをダウンロードできます。

今回はGoogleのGemma2を使ってみようと思います「Download」を押してモデルをダウンロードします。

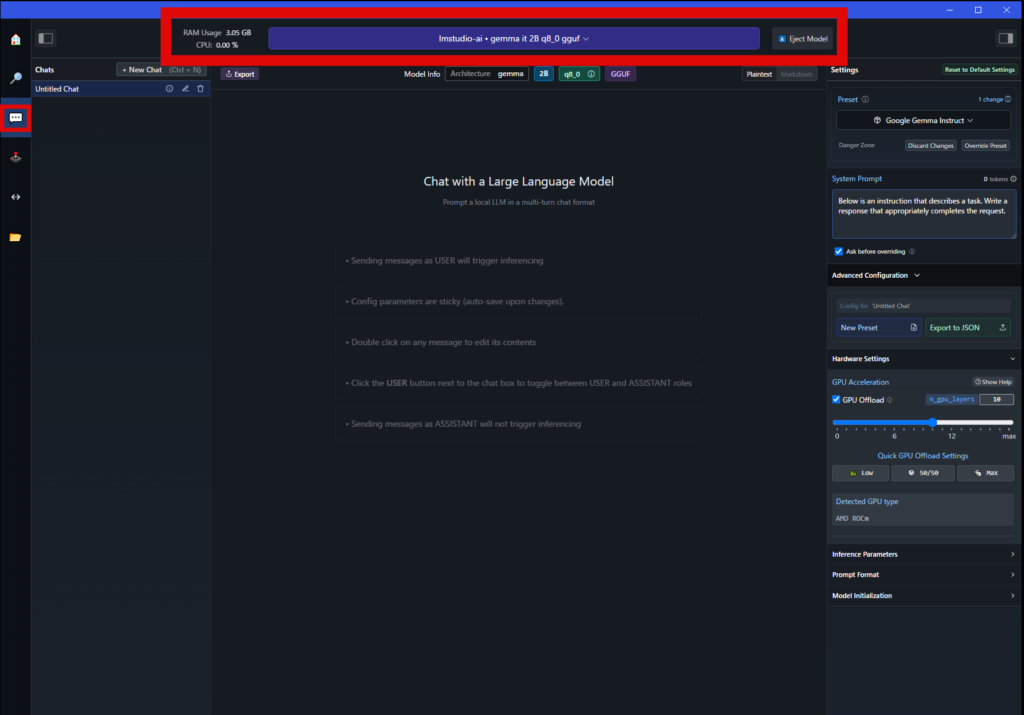

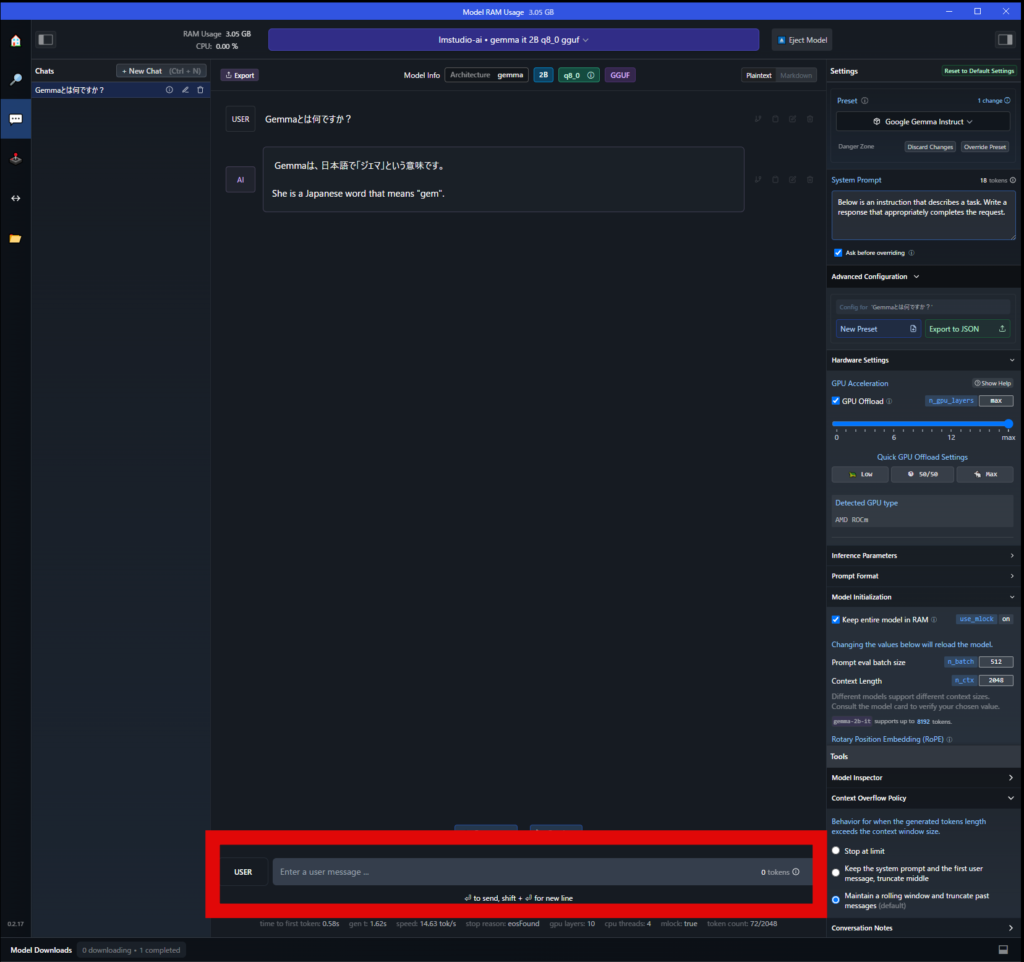

モデルのダウンロードが完了したらチャットのタブに移動しモデルを選択してください。

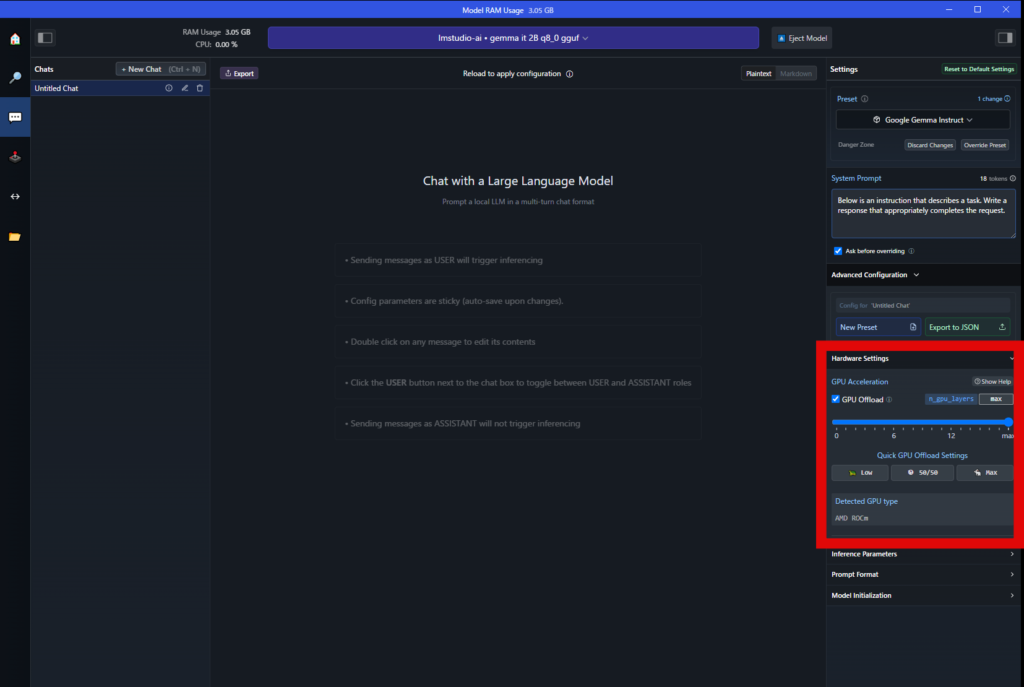

「GPU Offload」の設定にチェックが入っていればGPUを利用できます。

設定が完了すればメッセージの入力欄にプロンプトを入力すればチャットが始めれます。

あとがき

今回はRadeon GPUを搭載したPCでLLMを実行してみました。

複雑な設定やプログラミングの知識を必要なく簡単にチャットを始めることができました。

LM Studio自体はMacやGPUを搭載していないPCでも動かせるので興味があれば試してみてください。