2025年4月5日、Metaは新たなAIモデル「Llama 4」シリーズのリリースを発表しました。これにより、マルチモーダルAI(画像、動画、テキストを統合的に扱えるAI)分野での新時代が幕を開けました。

「Llama 4 Scout」と「Llama 4 Maverick」は、初めてオープンウェイトで提供されるネイティブなマルチモーダルモデルです。これらのモデルは前世代のモデルより大幅にパフォーマンスが向上しており、画像やテキスト理解において業界トップクラスの性能を誇ります。

Llama 4 Scout

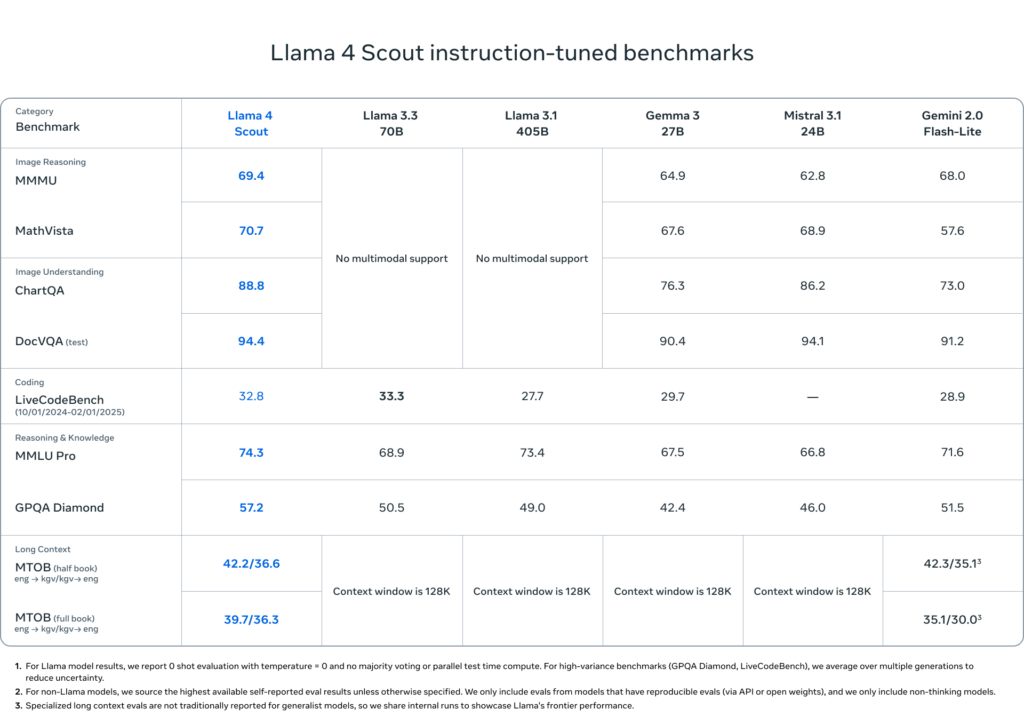

「Llama 4 Scout」は17億個のアクティブパラメータと16のエキスパートを備え、NVIDIAのH100 GPU単一で動作可能です。このモデルは、最大1千万トークンのコンテキスト長をサポートし、Gemma 3やGemini 2.0 Flash-Lite、Mistral 3.1を含む競合モデルを凌駕する性能を発揮します。コード解析、大規模な文書の要約、個別ユーザーの活動データ解析など、高度な用途に最適化されています。

Llama 4 Maverick

「Llama 4 Maverick」は同じく17億個のアクティブパラメータを持ちつつ、128のエキスパートを搭載。GPT-4oやGemini 2.0 Flashを超えるパフォーマンスを提供し、DeepSeek v3と比較しても半分以下のアクティブパラメータで同等の推論とコーディング能力を実現しています。Llama 4 MaverickはLMArenaにおいてもELOスコア1417という高い評価を受けており、性能とコストのバランスで業界をリードしています。

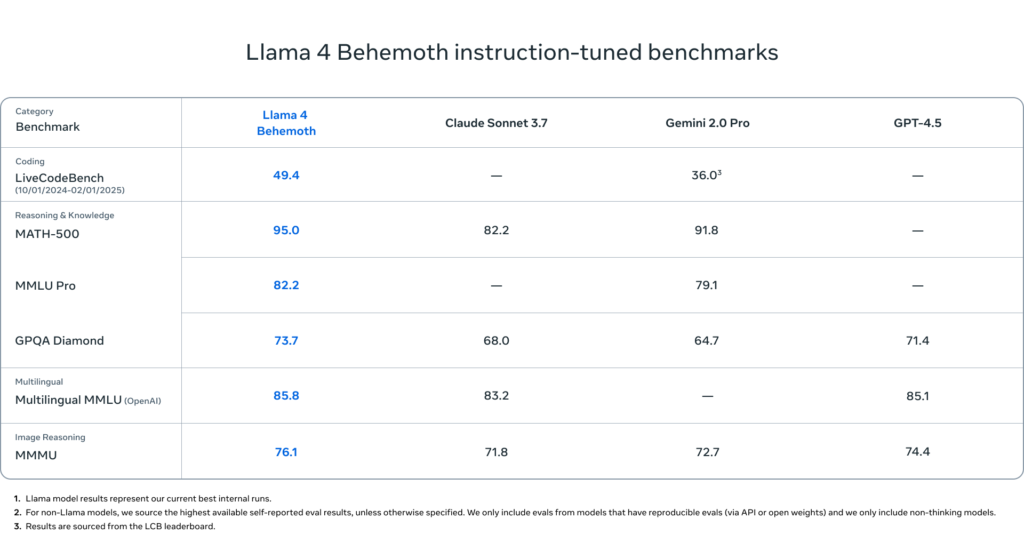

最先端の教育モデル「Llama 4 Behemoth」

さらにMetaは「Llama 4 Behemoth」という288億個のアクティブパラメータと16のエキスパートを持つモデルも開発しています。このモデルはSTEM分野のベンチマークでGPT-4.5、Claude Sonnet 3.7、Gemini 2.0 Proを上回る性能を示しています。まだトレーニング中ですが、将来的には他のLlama 4モデルの教育役として活用される予定です。

オープンソースとAIコミュニティへの貢献

Metaはオープンなモデル提供がイノベーションを推進するとして、今回の新モデルをllama.comとHugging Faceで一般公開しています。また、WhatsAppやMessenger、Instagram DirectなどMetaの各種サービスでも利用可能になります。

技術的な進化と革新

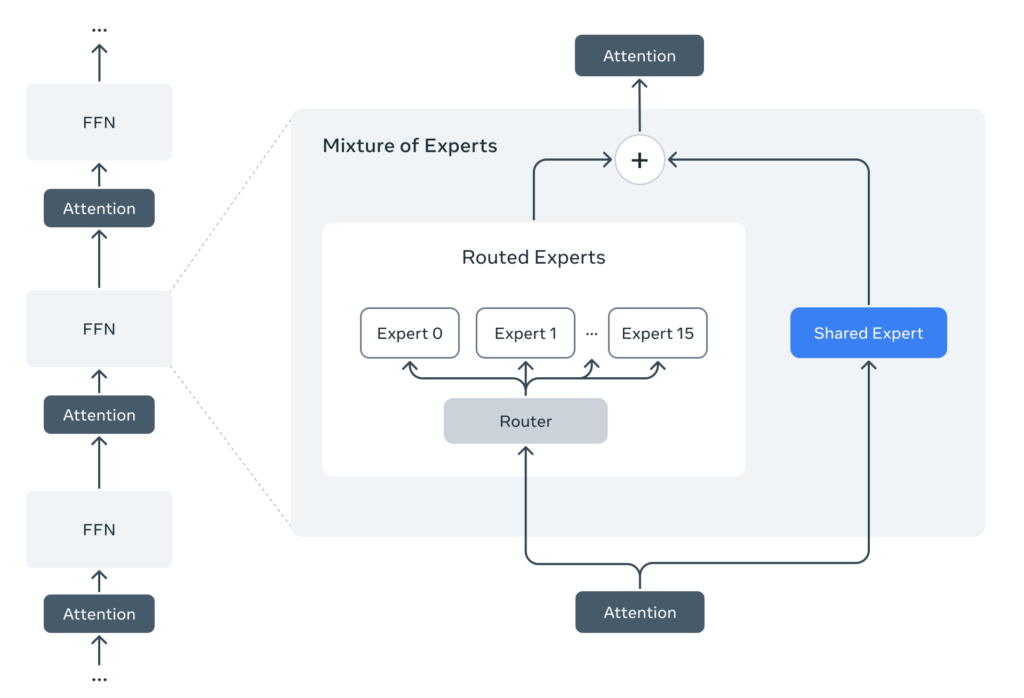

Llama 4シリーズはMixture-of-Experts(MoE)アーキテクチャを初めて採用し、マルチモーダル統合を早期から行うことで、テキスト・画像・動画データを効率的に融合したトレーニングを実現しました。また、Meta独自のMetaP技術によりモデルのハイパーパラメータ設定が最適化され、FP8精度での効率的なトレーニングを可能にしています。

AIセーフティとバイアス対策

Metaはモデルの安全性確保にも力を入れており、「Llama Guard」や「Prompt Guard」といったツールを公開し、開発者が安全で信頼性の高いAIアプリケーションを開発できるよう支援しています。

Metaの最新AIモデル「Llama 4」シリーズは、マルチモーダルAIの未来を大きく広げるものであり、AI業界に新たな競争をもたらすことが期待されています。

引用