Mistral AIチームは7月16日、クレオパトラの悲劇的な運命に敬意を表して、コード生成に特化したMamba2言語モデル「Codestral Mamba」をApache 2.0ライセンスの下で公開しました。

Mixtralファミリーの公開に続き、Codestral Mambaは新しいアーキテクチャの研究と提供に向けた次の一歩です。このモデルは無料で使用、変更、配布が可能で、アーキテクチャ研究に新たな視点をもたらすことが期待されています。

Codestral Mambaの設計にはAlbert Gu氏とTri Dao氏の協力がありました。

Transformerモデルとは異なり、Mambaモデルは線形時間推論と無限長のシーケンスを理論上モデル化する能力を提供します。

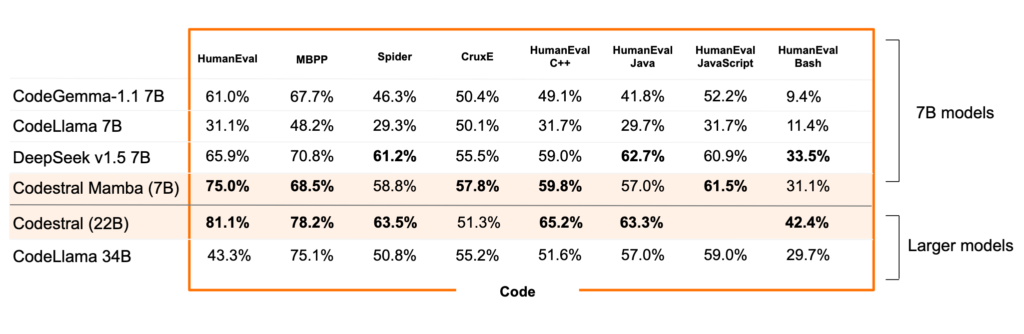

この効率性は特にコード生産性の向上に関連しており、高度なコード生成と推論能力を持つこのモデルは、最先端のTransformerベースのモデルと同等の性能を発揮します。

詳細なCodestral Mambaのベンチマーク

Codestral Mambaは最大256kトークンのコンテキスト内検索能力でテストされており、優れたローカルコードアシスタントとなることが期待されています。

このモデルはmistral-inference SDKを使用してデプロイでき、MambaのGitHubリポジトリからのリファレンス実装に依存しています。

また、TensorRT-LLMを通じてデプロイすることも可能です。

ローカル推論にはllama.cppでのサポートが期待されており、HuggingFaceから生のウェイトをダウンロードすることができます。

このモデルは7,285,403,648パラメータを持つ指示モデルです。

簡単にテストするために、Codestral Mambaは「la Plateforme」(codestral-mamba-2407)で利用可能であり、その大きな姉妹モデルであるCodestral 22Bも同様に利用できます。

Codestral MambaはApache 2.0ライセンスの下で提供され、Codestral 22Bは自己デプロイメント用の商用ライセンスまたはテスト目的のコミュニティライセンスで利用可能です。

引用