Intel Vision 2024において、新たに加わった顧客とパートナーを含め、インテルのAI全体にわたる協業を通じたオープンかつセキュリティーがさらに強化されたエンタープライズAIへの全面的な取り組みを発表

ニュースハイライト:

- インテルは、AIのあらゆるセグメントを横断したオープンかつスケーラブルなシステムによる包括的なエンタープライズ向けAI戦略を公開

- わずかなコストでありながらNVIDIA H100と比較して平均50%高い推論パフォーマンス*1 と平均40%高い電力効率*2 を実現する、インテル® Gaudi® 3 AI アクセラレーターを発表

- Dell Technologies、HPE、Lenovo、SupermicroをはじめとするOEM各社にインテル® Gaudi® 3 AI アクセラレーターの提供開始を発表。エンタープライズ向けAIデータセンター市場への展開を拡大

- Bharti Airtel、Bosch、CtrlS、IBM、IFF、Landing AI、Ola、NAVER、NielsenIQ、Roboflow、Seekrと数多くの顧客企業やパートナー企業がインテル® Gaudi® アクセラレーターの採用を発表

- インテルは、SAP、RedHat、VMware やその他の業界リーダーとの協力により、検索拡張生成(RAG)によって可能になるセキュアな生成AIシステムの導入を加速する、エンタープライズAI向けオープン・プラットフォームの共同開発を進める意向を発表

- インテルは高性能イーサネット通信規格を策定するUltra Ethernet Consortium(UEC)と連携し、AIファブリック用のオープン・イーサネット・ネットワーキングを主導。AI対応ネットワーク・インターフェイス・カード(NIC)、AI接続チップレットなどAI に最適化された一連のイーサネット ソリューションを紹介

インテル コーポレーション(米国アリゾナ州フェニックス)は顧客とパートナーを対象としたカンファレンス「Intel Vision 2024」で、エンタープライズ環境の生成AIにパフォーマンス、オープンさ、選択肢を提供するインテル® Gaudi® 3 AI アクセラレーターを発表しました。また同時に、オープンかつスケーラブルな新システムと次世代製品、生成AIの採用を加速する戦略的コラボレーションを公開しています。生成AIプロジェクトを本番稼働へ移行できた企業はわずか10%にとどまった昨年の状況を受け、AIイニシアチブを拡大していくうえで企業が直面しているこの課題にインテルの最新製品が対処します。

インテル コーポレーションCEO(最高経営責任者)のパット・ゲルシンガー(Pat Gelsinger)は、「かつてないペースでイノベーションが進化する中、そのすべてを可能にしているのがシリコンです。あらゆる企業が急速にAI対応の組織へと移行しています。インテルはPCからデータセンター、そしてエッジと、企業全体にAIを浸透させています。インテル® Gaudi® アクセラレーター、インテル® Xeon® プロセッサー、インテル® Core™ Ultra プロセッサーという最新のプラットフォームには、変化する顧客やパートナーのニーズに応え、この先に広がる巨大なチャンスを最大限に活かすために設計された、柔軟なソリューションを結集しました」と述べています。

多くの企業が生成AIをパイロット運用から本番稼働へ移行したいと考えています。これを成功させるには、コスト・パフォーマンスと電力効率の向上、複雑さや断片化といった課題の解消を意図して設計された、データ・セキュリティーとコンプライアンス準拠などの要件を満たす、インテル® Gaudi® 3 AI アクセラレーターのような導入後すぐに利用できるソリューションが不可欠です。

AIの学習処理と推論に特化したインテル® Gaudi® 3 AI アクセラレーターの登場

インテル® Gaudi® 3 AI アクセラレーターは、数万ものアクセラレーターを共通のイーサネット標準規格で接続し、AIシステムを駆動します。インテル® Gaudi® 3 AI アクセラレーターでは、前世代よりもBF16のAI演算処理が4倍、メモリー帯域幅が1.5倍に拡大しました。このアクセラレーターによって、生成AIをグローバル規模に拡張したいと考えている企業は、AIの学習処理と推論の大幅な向上が見込まれます。

インテル® Gaudi® 3 AI アクセラレーターは、70億パラメーター、130億パラメーターを持つ各Llama2モデル、1,750億パラメーターのGPT-3モデルを使用した場合に、NVIDIA H100と比較して学習処理を平均50%高速化*3 することが見込まれます。さらに、インテル® Gaudi® 3 AI アクセラレーターの推論スループットは、70億パラメーターと700億パラメーターのLlamaモデル、1,800億パラメーターのFalconモデルでH100よりも平均50%*1、推論の電力効率は平均40%*2 高くなると推定されます。

オープンなコミュニティー・ベースのソフトウェアと業界標準のイーサネット・ネットワーキングへの対応も、インテル® Gaudi® 3 AI アクセラレーターの特長です。また単一ノードからクラスター、スーパークラスター、そして数千ノード構成のメガクラスターまで柔軟に拡張できるため、企業は最大規模での推論、ファイン・チューニング、学習処理が可能になります。

インテル® Gaudi® 3 AI アクセラレーターは、2024年第2四半期に、Dell Technologies、HPE、Lenovo、Supermicroをはじめとするシステム・メーカー各社への量産品の提供開始が予定されています。

詳しくは、Intel Tackles the GenAI Gap with Gaudi 3(英語) を参照してください。

顧客に価値を創出するインテルのAIソリューション

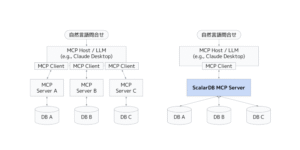

インテルは今回のカンファレンスで、ハードウェア、ソフトウェア、フレームワーク、ツールを含む、オープンかつスケーラブルなAIシステムによる戦略の全体像を明らかにしました。インテルのアプローチにより、AI開発の広範なオープン・エコシステムを通じて、生成AIに対するエンタープライズ固有の要件を満たすソリューションを提供できるようになります。ここには機器メーカー、データベース・プロバイダー、システム・インテグレーター、ソフトウェア・プロバイダー、サービス・プロバイダーなども含まれ、企業は既知であり信頼できるエコシステム・パートナーとソリューションを選択することができます。

インテルは、新しい革新的な生成 AI アプリケーション向けの Intel Gaudi アクセラレーター ソリューション展開に向けた、幅広い業界における企業顧客やパートナーの導入状況を紹介しました。

- NAVER:クラウドからオンデバイスまで最先端のAIサービスをグローバルに展開する、強力なLLMモデルの開発に向けて、NAVERは、大規模なTransformerモデルの演算処理を卓越したワット当たりパフォーマンスで実行するインテル® Gaudi® アクセラレーターの基本的な能力を確認済みです。

- Bosch:スマート製造のさらなる機会拡大を探求し、基本モデルをはじめ、合成データセットを生成して、製造プロセスの異常検出など自動光学検査に使用できる安定した均一の学習データセットを提供します。

- IBM:独自のwatsonx.data™ データストアに第5世代 インテル® Xeon® スケーラブル・プロセッサーを導入し、インテルとの緊密な連携によってwatsonxプラットフォームにインテル® Gaudi® アクセラレーターを実装して検証しています。

- Ola/Krutrim:10言語に対応する同社初のインド基本言語モデルの事前学習とファイン・チューニングで、市場ソリューションと比べて業界トップレベルのコスト・パフォーマンスを実現。Krutrimでは現在、インテル® Gaudi® 2 AI アクセラレーター搭載クラスターで大規模な基本言語モデルの事前学習を実行中です。

- NielsenIQ(Advent Internationalのポートフォリオ企業):独自の生成AI機能を拡張するために、世界最大規模の消費者購買行動データベースでドメイン固有のLLMに学習処理を行い、厳しいプライバシー保護基準を遵守しながら、クライアント・サービスの品質を向上させています。

- Seekr:信頼できるAIソリューションを提供するトップ企業の1社。LLMの開発と本番環境への導入にインテル® Tiber™ デベロッパー・クラウドを活用し、インテル® Gaudi® 2 AI アクセラレーター、インテル® データセンター GPU マックス・シリーズ、インテル® Xeon® プロセッサーで本番環境のワークロードを実行しています。

- IFF:食品、飲料、香料、生物科学の業界を牽引する世界的企業のIFFは、高度な酵素設計と発酵プロセスを最適化する統合型のデジタル生物学的ワークフローを確立するために、生成AIとデジタルツインを活用しています。

- CtrlS Group:インドに拠点を置く顧客向けに共同でAIスーパーコンピューターを構築。インド国内のCtrlSクラウドサービス拡大のため、インテル® Gaudi® AI アクセラレーター搭載クラスターを増設しました。

- Bharti Airtel:Airtelは、インテルの最先端技術を採用し、同社の豊富な通信データを活用してAI機能を強化し、顧客の体験を飛躍的に向上させる計画。今回の導入を通じて、技術革新の最前線に立ち続け、急速に進化するデジタル環境の中で新たな収益源の確保を促進させる同社のコミットメントを果たします。

- Landing AI:ドメイン固有の大規模ビジョンモデルをファイン・チューニングし、細胞のセグメント区分とがんの発見に活用します。

- Roboflow:エンドツーエンドのコンピューター・ビジョン・プラットフォームで、YOLOv5、YOLOv8、CLIP、SAM、ViTといったモデルの本番ワークロードを実行します。

- Infosys:次世代デジタルサービスおよびコンサルティングのグローバルリーダーであるInfosysは、第4世代/第5世代 インテル® Xeon® プロセッサー、インテル® Gaudi® 2 AI アクセラレーター、AI PCを含むインテルのテクノロジーを、AIファーストのサービス、ソリューション、プラットフォームであるInfosys Topazに導入するための戦略的協業を発表しました。

またインテルは、Google Cloud、Thales、Cohesityとのコラボレーションによる、インテルのコンフィデンシャル・コンピューティング機能を各社のクラウド・インスタンスに実装する計画を発表しました。これにはインテル® トラスト・ドメイン・エクステンションズ(インテル® TDX)、インテル® ソフトウェア・ガード・エクステンションズ(インテル® SGX)、インテルの認証サービスなどが含まれます。顧客企業は信頼できる実行環境(TEE)で独自のAIモデルやアルゴリズムを実行できるほかし、インテルの信頼できる認証サービスを利用してTEEの信頼性を独自に検証できます。

エンタープライズAIのオープン・プラットフォーム開発を推進するために集結したエコシステム

インテルは、Anyscale、Articul8、DataStax、Domino、Hugging Face、KX Systems、MariaDB、MinIO、Qdrant、RedHat、Redis、SAP、VMware、Yellowbrick、Zillizとの連携による、エンタープライズAI向けオープン・プラットフォームの共同開発の意向を発表しました。この業界一体の取り組みが目指すのは、検索拡張生成(RAG)によって可能になった導入しやすさと、クラス最高のパフォーマンスと価値を提供するオープンなマルチベンダー生成AIシステムの開発です。RAGは、標準的なクラウドインフラストラクチャ上で実行されている企業の膨大な既存の独自データソースを、オープンなLLM機能で拡張できるようにし、企業における生成利用を加速させます。

インテルはこの取り組みの初期段階として、安全なインテル® Xeon®/インテル® Gaudi® ベースのソリューション上での生成AIパイプライン用リファレンス実装のリリース、技術的な概念フレームワークの公開、インテル® Tiber™ デベロッパー・クラウドで提供するインフラストラクチャー機能の継続的な追加を通じ、エコシステムにおけるRAGや将来的なパイプラインの開発と検証を推進していく計画です。このオープンな取り組みにより企業での採用促進、ソリューションの領域拡大、ビジネス成果実現の加速化に向け、インテルはエコシステムのさらなる参画を奨励しています。

インテルのAIロードマップとオープン・エコシステム・アプローチの拡大

インテルは、インテル® Gaudi® 3 AI アクセラレーターのほか、エンタープライズAIのすべてのセグメントにわたる次世代の製品とサービスに関する最新情報を紹介しました。

インテル® Xeon® 6 プロセッサーの登場:インテル® Xeon® プロセッサーは、独自のデータを使用してビジネス特有の結果を出力するRAGなど、現在の生成AIソリューションを実行する、パフォーマンスと効率性を兼ね備えたプラットフォームです。インテルはデータセンター、クラウド、エッジを対象とする次世代プロセッサーの新ブランドとして、インテル® Xeon® 6 プロセッサーを発表しました。新しいEfficient-cores(E-core)を搭載したインテル® Xeon® 6プロセッサーは、卓越した効率性を実現し、今四半期に発表される予定です。一方、Performance-cores(P-core)を搭載したインテル® Xeon® 6プロセッサーは、AI性能を向上させ、E-core搭載インテル® Xeon® 6プロセッサーに続きは提供開始される予定です。

- E-cores搭載インテル® Xeon® 6 プロセッサー(開発コード名:Sierra Forest):

- 第2世代 インテル® Xeon® スケーラブル・プロセッサーと比較して、2.4倍のワット当たりパフォーマンス*4 と2.7倍のラック密度5 を実現します。

- 旧システムをほぼ3分の1に置き換え可能。消費電力を大幅に削減して、サステナビリティー目標の達成を支援します*6。

- P-cores搭載インテル® Xeon® 6 プロセッサー(開発コード名:Granite Rapids):

- MXFP4データ・フォーマットにソフトウェア・サポートを組み込み、第4世代インテル® Xeon® スケーラブル・プロセッサーと比較して次のトークンを受け取るまでの時間を最大6.5分の1に低減して、700億パラメーターのLlama-2モデルを実行できます*7。

クライアント、エッジ、接続性:インテルのクライアント製品の発表と同時に、エッジと接続ソリューションのロードマップが更新されています。

- インテル® Core™ Ultra プロセッサーでは、生産性タスク、セキュリティー、コンテンツ制作の新機能を強化。社内のPC更新を促す、格好のきっかけを提供します。2024年には、超薄型PCから携帯型のゲーミングデバイスまで230以上の機種を取り揃えて、4,000万台のAI PCが出荷される見込みです。

- 2024年リリース予定のクライアント向け次世代インテル® Core™ Ultra プロセッサー(開発コード名:Lunar Lake)は、次世代のAI PCにふさわしい1秒当たり100兆回超のプラットフォーム処理性能(100 TOPS)を有し、45 TOPSを上回るニューラル・プロセシング・ユニット(NPU)を搭載しています。

- 小売、工業製造、ヘルスケアなどの主要市場を対象に、インテル® Core™ Ultra プロセッサー、インテル® Core™ プロセッサー、Intel Atom® プロセッサー、インテル® Arc™ グラフィックス・プロセシング・ユニット(GPU)にわたる、エッジ対応の新シリコン製品を発表。新たにインテルのエッジAI製品ポートフォリオに加わるこれらの製品はすべて、今四半期に提供開始となり、今年インテル® Tiber™ エッジ・プラットフォームに対応する予定です。

- インテルは高性能イーサネット通信規格を策定するUltra Ethernet Consortium(UEC)と連携し、AIファブリック用のオープン・イーサネット・ネットワーキングを主導する、AIに最適化された多種多様なイーサネット・ソリューションを発表。このイノベーション技術は、AIファブリックのスケールアップとスケールアウトを大きく変革するために設計され、世代を追うごとに桁違いの拡大をもたらし、ますます大規模化するモデルの学習処理と推論を可能にしました。このラインナップには、インテルのAI対応ネットワーク・インターフェイス・カード(NIC)、AI接続チップレットのXPUへの統合、インテル® Gaudi® プラットフォーム・ベースのシステム、インテル・ファウンドリーでの製造に対応するソフトウェアとハードウェアの幅広いリファレンスAIインターコネクト・デザインが含まれます。

ビジネス向けソリューションを提供するインテル® Tiber™ ポートフォリオ

生成AIアプリケーションを含め、企業環境へのソフトウェアやサービスの導入を効率化する、ビジネス向けソリューションのインテル® Tiber™ ポートフォリオを公開しました。

企業顧客と開発者に一体型の体験を提供できれば、セキュリティー、コンプライアンス、パフォーマンスのいずれも妥協することなく、ニーズに合ったソリューションを見つけ、イノベーションを加速し、価値を最大限に引き出すことも難しくはありません。インテル® Tiber™ ポートフォリオは本日より顧客企業の皆様に提供開始となっており、2024年第3四半期には全面的な展開が予定されています。詳細は、Intel Tiber websiteにアクセスしてご確認ください。

Intel Vision 2024で発表となったインテルの最新情報は、世界中の企業にとって利用しやすくオープンで安全なAIの提供を目指すインテルの積極的な取り組みを強調するものです。インテルはこれらの新しいソリューションとコラボレーションによりAI革命が進む道をリードする態勢を整え、場所を問わずあらゆる企業にかつてない価値をもたらしています。

引用