本記事では、ローカル環境で大規模言語モデル(LLM)を実行できるAIプラットフォーム「Ollama」の概要とその利用方法について解説します。

Ollamaとは?

Ollamaは、自身のPC上でLLMを実行できるローカルAIプラットフォームです。

従来のクラウドベースのLLM利用と異なり、インターネット接続が不要であるため、データのプライバシーを確保しながら高度なAI機能を利用できます。

また、ネットワーク遅延がないため、即時応答が可能で、専用サーバーやクラウド利用料も不要です。

OllamaはオープンソースのLLMモデルを多くサポートしており、簡単な設定で手軽に利用できます。。

主な特徴

- ローカル実行のためプライバシーが保護される – 自身のPC内で処理が完結するため、データが外部に漏洩するリスクが少ない。

- インターネット接続不要 – クラウド利用と異なり、オフラインでもモデルを動作可能。

- リアルタイム応答 – ネットワーク遅延がないため、即時に応答が得られる。

Ollamaの使い方

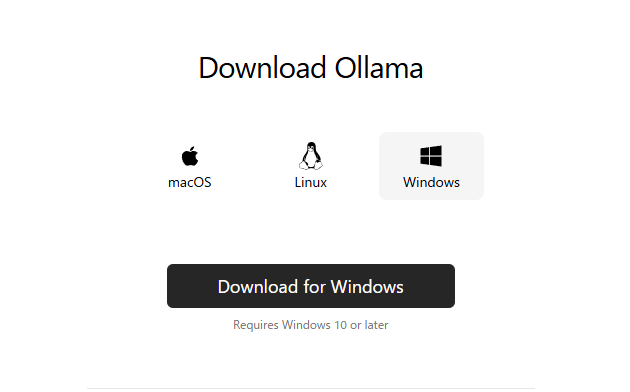

今回の解説では、Windows環境での利用手順を紹介します(MacやLinuxでは手順が異なる場合がありますのでご注意ください)。

また、LLMの動作には高いPCスペックが必要になることがあります。

利用環境

- OS: Windows 10

- GPU: GeForce RTX 4080

インストール手順

公式サイトから「Download for Windows」をクリックし、インストーラーをダウンロードします。

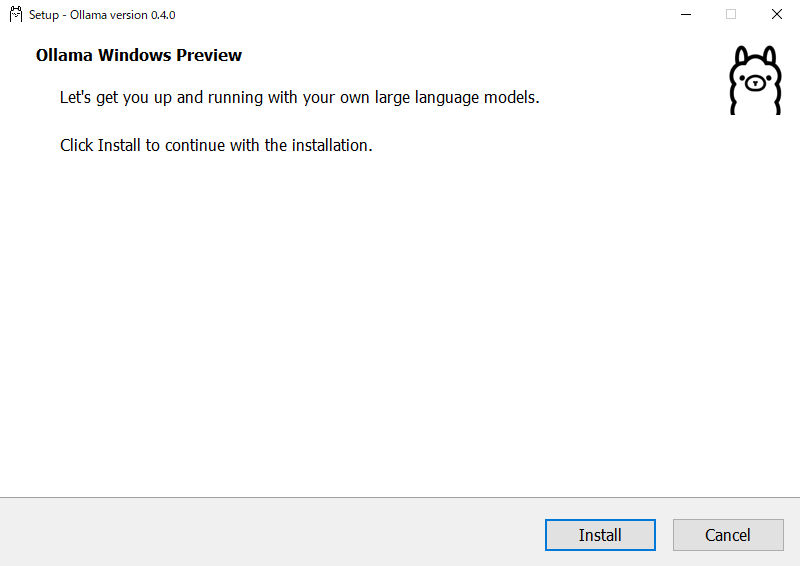

ダウンロードしたインストーラー「OllamaSetup.exe」を実行し、ガイドに従ってOllamaをPCにインストールします。

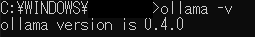

インストール完了後、コマンドプロンプトで ollama -v と入力し、Ollamaのバージョンが表示されることを確認します。

モデルのダウンロードと実行

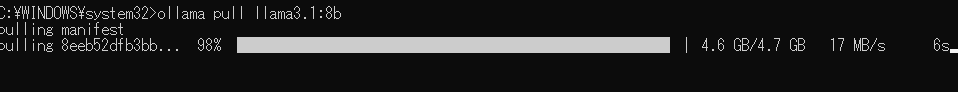

今回は軽量モデルのLlama3.1 8Bをダウンロードします。

ollama pull llama3.1:8b

このコマンドにより、モデルのダウンロードが開始されます。

モデルのダウンロードが完了したら、以下のコマンドでモデルを実行できます。

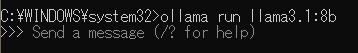

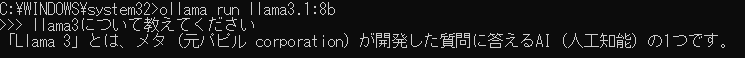

ollama run llama3.1:8b実行後、対話形式のプロンプトが表示され、LLMと直接やり取りが可能になります。

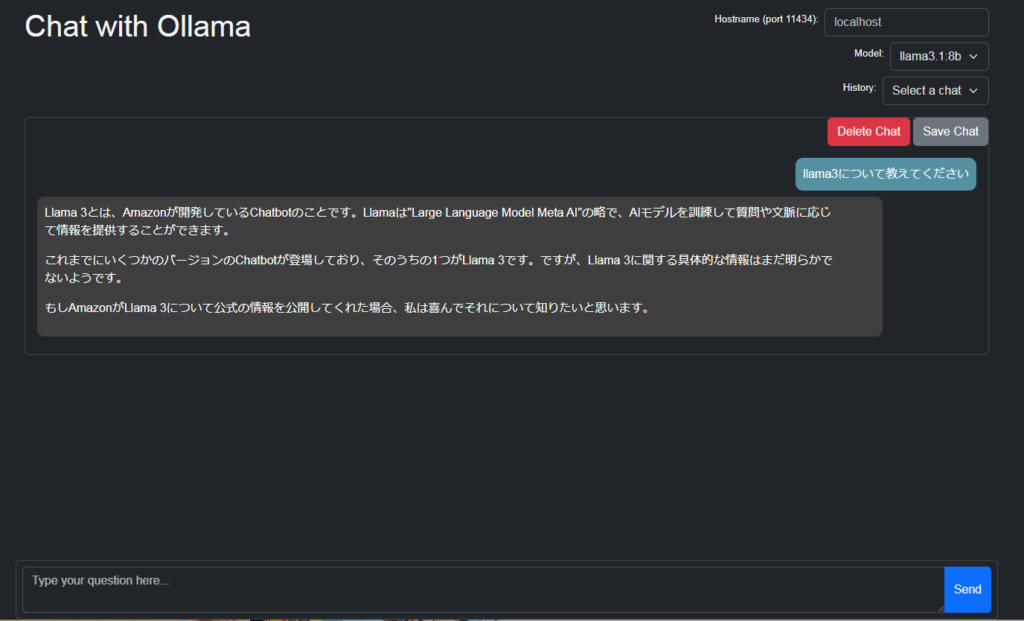

試しにLlama3について聞いてみました。

軽量なモデルということもあり実用性は低いかなと思います。

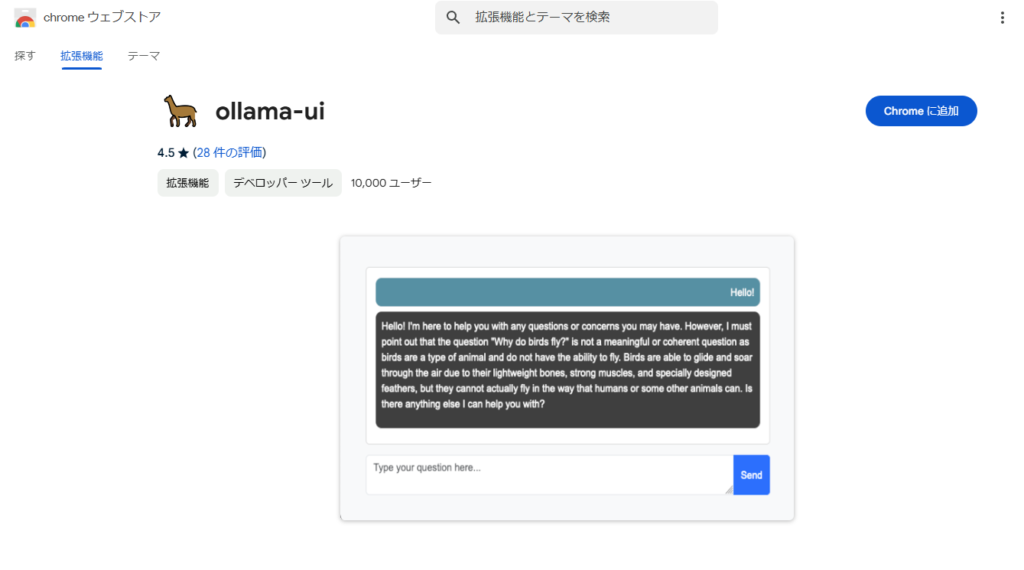

Chrome拡張機能「ollama-ui」の利用

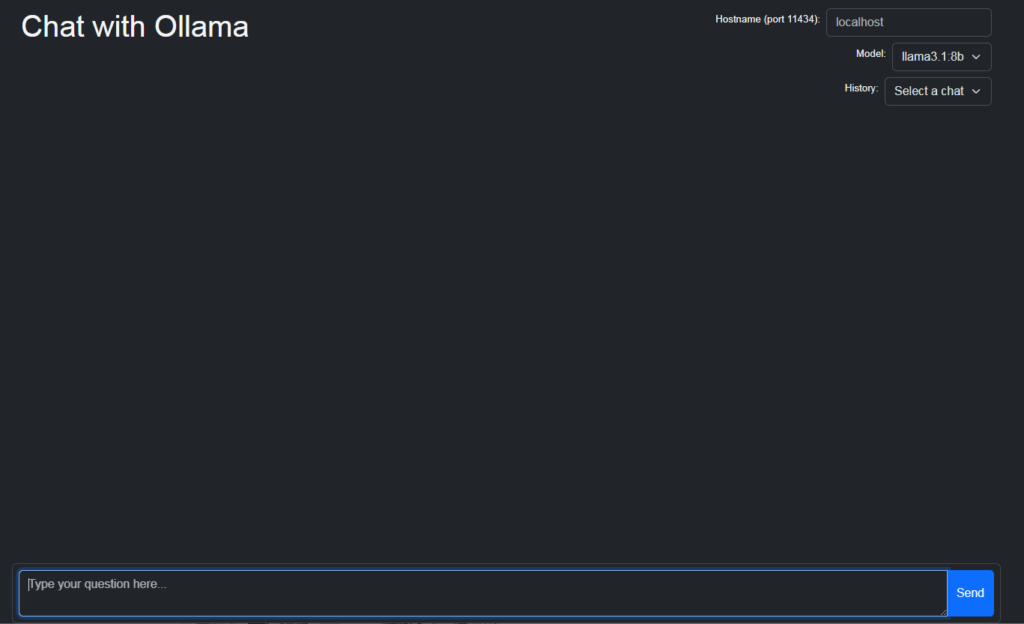

Chrome拡張機能として提供されている「ollama-ui」をChromeブラウザに追加することでChromeブラウザ上でOllamaを使う事もできます。

ollama-uiを利用することで、簡単にブラウザからAIチャットを利用できます。

おわりに

今回は、Windows環境におけるOllamaのインストールからLlama 3.1 8Bモデルの実行までの手順を解説しました。

ローカル環境でLLMを利用することで、ネットワークに依存しない環境や高いセキュリティ要件が求められる環境においても、LLMの高度な機能を活用できます。

また、Ollamaを使えばLlama 3.1 8B以外の多様なモデルもローカルPCで実行できるため、ぜひ興味のあるモデルで試してみてください。