ポイント

- Stable Code 3Bは、30億パラメータを持つ大規模言語モデル(LLM)であり、CodeLLaMA 7bのような2.5倍の大きさを持つモデルと同等のレベルで、正確で応答性の高いコード補完を可能にします。

- MacBook Airのような一般的なノートパソコンでGPUがなくてもオフラインで動作します。

- モデルを商用利用するためには Stability AI メンバーシップ へのご登録をお願いします。

2024年最初の大規模言語モデルのリリースを発表します。 Stable Code 3B です。 この新しいLLMは、先にリリースされた Stable Code Alpha 3B に続くもので、Stable Codeの最初の大規模リリースとなります。

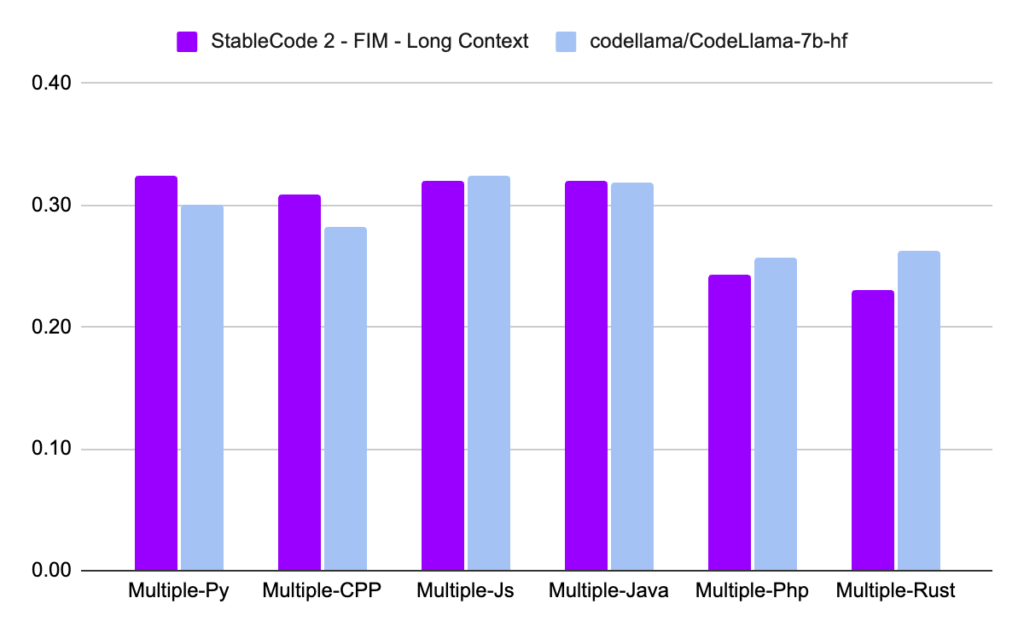

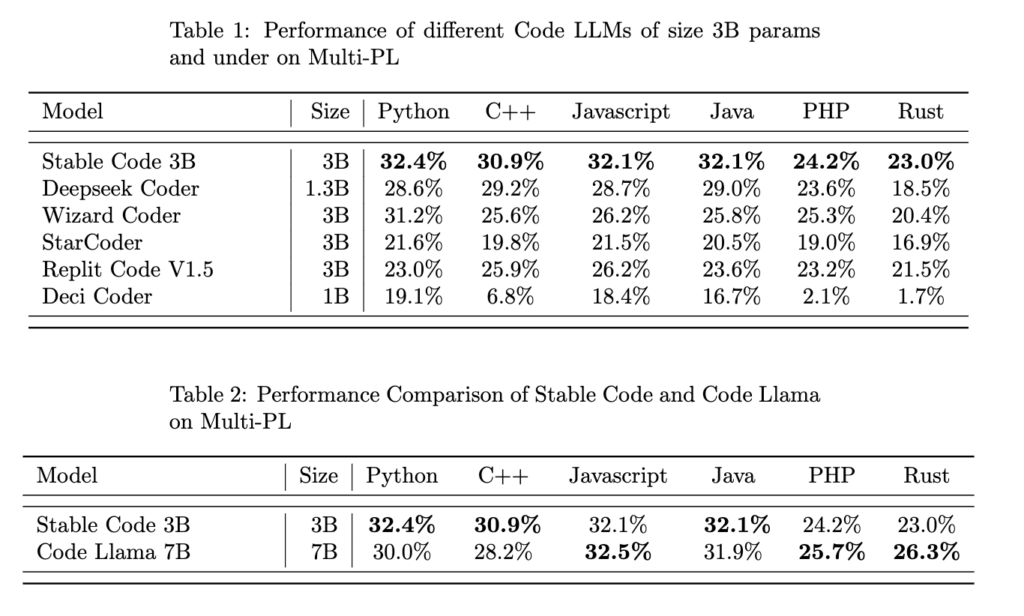

CodeLLaMA 7bと比較すると、Stable Code 3Bは60%小型化されている一方で、プログラミング言語全体において同様のハイレベルなパフォーマンスを発揮します。Stable Codeは、4兆トークンの自然言語データでトレーニングされた既存の Stable LM 3B の基礎モデルをベースに、コードを含むソフトウェアエンジニアリング固有のデータでさらにトレーニングされました。このモデルはコンパクトなサイズであるため、専用GPUを搭載していない最新のラップトップでも、エッジ上でプライベートなリアルタイム実行が可能です。

Stable Code 3Bは、FIM (Fill in the Middle)機能のサポートやコンテキストサイズの拡張など、多言語にわたってより多くの機能と大幅に向上したパフォーマンスを提供します。Stable Code 3Bは、最大16,384トークンのシーケンスで学習されますが、CodeLlamaと同様のアプローチでRotary Embeddingsが実装されており、オプションでRotary Baseを最大1,000,000まで変更することができます。

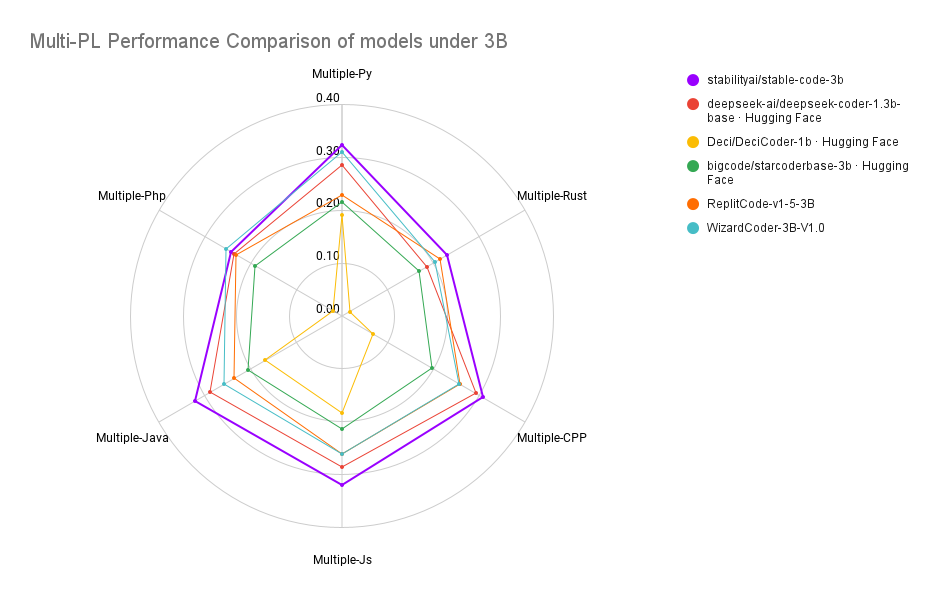

Stable Codeは、18のプログラミング言語 (2023 StackOverflow Developer Survey) で学習され、テストされた複数のプログラミング言語にわたって、MultiPL-Eメトリクスで(同規模のモデルと比較して)最先端のパフォーマンスを示しています。

性能比較

トレーニングインサイト

この学習パイプラインは Codellama と同様の多段階プロセスで構成されています。まず、自然言語データ(StableLM-3B-4e1t) で事前に訓練されたLMから始め、CommitPack、GitHub Issues、StarCoder、その他の数学データセットなど、複数のコードやコード関連データセットで、教師なしファインチューニングを行います。第2ステップでは、CodeLLamaで提案された基本的な修正を加えた16,384トークンの長いシーケンスでモデルをさらに微調整しました。新しいstable-codeモデルはFlash Attention 2もサポートしており、利用可能です。

データとモデルに関する詳しい情報は、モデルカードをご覧ください。私たちは、コミュニティに対してより透明でオープンであるために、詳細とアブレーションを追加した完全なテクニカルレポートを発表する予定です。

商用利用について

このモデルは Stability AI メンバーシップ に含まれます。SDXL Turbo や Stable Video Diffusion を含む商業用コアモデルをご利用になるには、Stability AI メンバーシップ ページをご参照ください。

引用